بزرگترین خبرهای رویداد فناورانه AWS re:Invent ۲۰۲۵

کنفرانس سالانه «AWS re:Invent ۲۰۲۵» شرکت «آمازون وب سرویسز (AWS)» این هفته در لاسوگاس برگزار میشود و از تراشههای هوش مصنوعی تا سرویسهای ابری و عاملهای هوشمند، موجی از خبرهای مهم را برای کسبوکارها به همراه داشته است.

تحلیلتمرکز اصلی رویداد، حرکت AWS از دستیارهای هوشمند به سمت «عاملهای هوش مصنوعی خودکار در سطح سازمانی» است که قادرند تصمیمگیریهای پیچیده را بدون مداخلهٔ مداوم انسان انجام دهند و مستقیماً ارزش اقتصادی ایجاد کنند.

تمرکز اصلی: عاملهای هوش مصنوعی در مقیاس سازمانی

روز اول برنامههای رسمی رویداد با انبوهی از معرفی محصول و سرویس جدید به پایان رسید؛ محور مشترک تقریباً همه این خبرها، «هوش مصنوعی برای سازمانها» و بهویژه نسل تازه «عاملهای هوشمند» بود که میتوانند کارها را بهطور خودکار برای مشتریان انجام دهند.

«مت گارمن، مدیرعامل AWS»، در سخنرانی آغازین خود تأکید کرد عاملهای هوش مصنوعی، مرحلهای فراتر از «دستیارهای هوشمند» هستند و جاییاند که بازگشت سرمایه واقعی از پروژههای هوش مصنوعی برای شرکتها شکل میگیرد.

تراشه Trainium۳ و همزیستی با انویدیا

AWS نسخهٔ جدید تراشه اختصاصی آموزش هوش مصنوعی خود با نام Trainium۳ و یک سیستم مبتنی بر آن بهنام UltraServer را معرفی کرد.

طبق اعلام AWS، این نسل جدید تا حدود «۴ برابر» توان پردازش بیشتر برای آموزش و استنتاج مدلهای هوش مصنوعی ارائه میدهد و همزمان مصرف انرژی را تا حدود «۴۰٪» کاهش میدهد، که برای مراکز دادهٔ بزرگ و هزینهٔ برق بالا، مزیت مهمی محسوب میشود.

AWS همچنین خبر داد که نسل بعدی این تراشه یعنی Trainium۴ در حال توسعه است و بهگونهای طراحی خواهد شد که بتواند در کنار تراشههای شرکت «انویدیا» در یک اکوسیستم مشترک کار کند؛ این یعنی AWS عملاً بهسمت معماری ترکیبی میرود تا وابستگی صرف به یک نوع تراشه برای مشتریانش ایجاد نشود.

گسترش پلتفرم AgentCore برای ساخت عاملها

AWS قابلیتهای جدیدی را برای پلتفرم ساخت عاملهای هوش مصنوعی خود با نام AgentCore معرفی کرد که هدف آن، کنترل و مدیریت دقیقتر این عاملها در محیطهای سازمانی است.

یکی از ویژگیهای مهم، ماژولی به نام Policy در AgentCore است که به توسعهدهندگان اجازه میدهد مرزها، محدودیتها و سیاستهای رفتاری عاملها را سادهتر و شفافتر تعریف کنند؛ این موضوع در سناریوهایی مثل بانک، بیمه یا دولت که خطای عامل میتواند پیامد حقوقی داشته باشد، اهمیت زیادی دارد.

نکته مفهومیعاملها در AgentCore حالا میتوانند رفتار و ترجیحات کاربران را ثبت و بهخاطر بسپارند و AWS برای کمک به مشتریان، «۱۳ سیستم ارزیابی از پیشساخته» ارائه کرده تا کیفیت، دقت و ایمنی عاملها را بهصورت ساختاریافته بسنجند.

«فرانتیر ایجنتها»: عاملهای خودکار که روزها کار میکنند

AWS سه عامل هوش مصنوعی جدید را با عنوان Frontier Agents معرفی کرد که هرکدام برای یک نیاز تخصصی در توسعه نرمافزار و عملیات فناوری طراحی شدهاند.

یکی از اینها، «عامل خودکار Kiro» است که برای نوشتن کد و یادگیری شیوهٔ کاری تیمها طراحی شده و بهگفتهٔ AWS میتواند پس از یادگیری الگوی کار، برای «ساعتها یا حتی روزها» بدون نیاز به مداخلهٔ مداوم انسان روی تسکها کار کند.

عامل دوم بر امنیت متمرکز است و وظایفی مانند بازبینی امنیتی کدها و فرایندهای نرمافزاری را انجام میدهد و عامل سوم هم کارهای DevOps مثل پیشگیری از خطاها هنگام استقرار نسخههای جدید را بر عهده میگیرد؛ نسخهٔ پیشنمایش این عاملها هماکنون برای مشتریان در دسترس است.

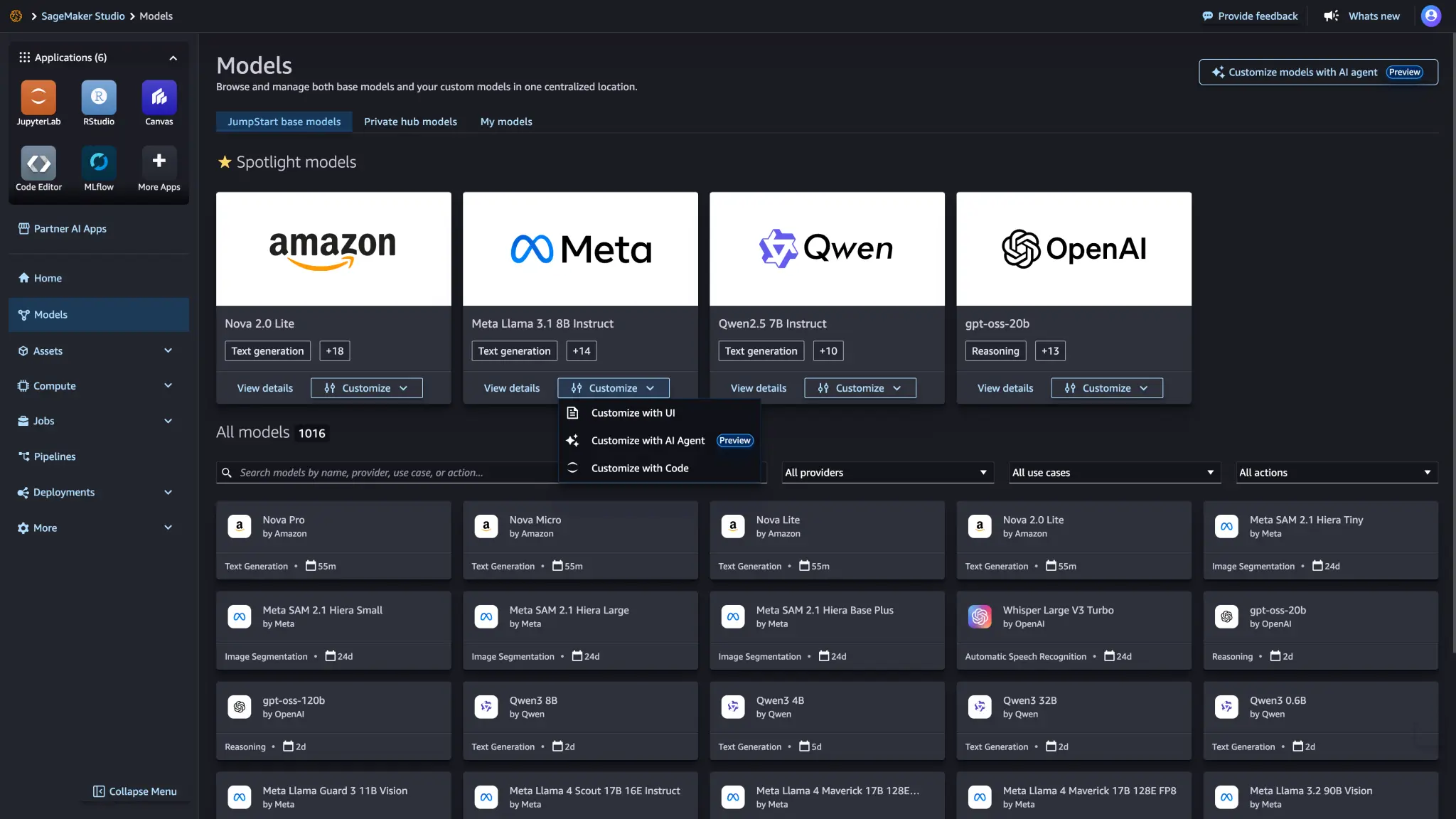

خانواده مدلهای Nova و سرویس Nova Forge

AWS چهار مدل جدید هوش مصنوعی را در خانواده Nova معرفی کرده است: سه مدل مولد متن و یک مدل چندرسانهای که هم متن تولید میکند و هم تصویر.

به موازات آن، سرویسی به نام Nova Forge رونمایی شد که به مشتریان ابری AWS اجازه میدهد از میان مدلهای «ازپیشتمرینشده»، «میانی» یا «پس از آموزش» انتخاب کنند و سپس آنها را با دادههای اختصاصی شرکت خود، آموزش تکمیلی بدهند.

گزارشرویکرد AWS در اینجا، ارائهٔ حداکثر «انعطافپذیری و شخصیسازی» است؛ یعنی شرکتها بهجای ساخت مدل از صفر، روی تنظیم و بهینهسازی مدلهای موجود برای دادهها و نیازهای کسبوکارشان تمرکز کنند که از نظر زمان و هزینه، برای بسیاری از شرکتهای ایرانی و بینالمللی بهصرفهتر است.

تجربهٔ «لیفت» از عاملهای AWS

شرکت تاکسی اینترنتی «لیفت (Lyft)» هم در جریان رویداد، تجربهٔ خود از استفاده از عاملهای هوش مصنوعی AWS را به اشتراک گذاشت.

لیفت اعلام کرد با استفاده از مدل Claude متعلق به شرکت Anthropic از طریق سرویس Amazon Bedrock، یک عامل هوش مصنوعی برای پاسخگویی به پرسشها و مشکلات رانندهها و مسافران ساخته است که توانسته «میانگین زمان رسیدگی به درخواستها را حدود ۸۷٪ کاهش دهد».

بهگفتهٔ لیفت، میزان استفادهٔ رانندگان از این عامل هوش مصنوعی در سال جاری حدود «۷۰٪ افزایش» داشته که نشان میدهد پذیرش این نوع سامانهها، در اکوسیستم حملونقل آنلاین روبهافزایش است؛ الگوی مشابهی میتواند در کسبوکارهای خدماتی آنلاین در ایران نیز پیادهسازی شود.

«کارخانهٔ هوش مصنوعی» برای دیتاسنترهای خصوصی

«آمازون» همچنین محصولی با عنوان «AI Factories» معرفی کرد که به سازمانهای بزرگ و دولتها اجازه میدهد سامانههای هوش مصنوعی AWS را نه در ابر عمومی، بلکه در دیتاسنترهای داخلی خودشان اجرا کنند.

این سیستم با همکاری «انویدیا» طراحی شده و هم سختافزار انویدیا و هم فناوری AWS را در بر میگیرد؛ سازمانها میتوانند آن را با GPUهای انویدیا مجهز کنند یا از تراشهٔ جدید Trainium۳ آمازون بهره ببرند.

نگاه بنیانگذارهدف اصلی، پاسخدادن به دغدغهٔ «حاکمیت داده» است؛ یعنی شرکتها و نهادهایی که بهدلیل قوانین داخلی یا ملاحظات امنیتی نمیخواهند دادههای حساسشان را به ابر عمومی بفرستند، اما همچنان میخواهند از مزیتهای هوش مصنوعی در مقیاس بزرگ استفاده کنند. برای مخاطب ایرانی، این رویکرد میتواند نمونهای از راهحلهای ترکیبی باشد که در سناریوهای تحریم و محدودیت دسترسی مستقیم به ابرهای بینالمللی مطرح میشود.

دسترسی سریع و ایمن به ابزارهای قدرتمند فناوری!